L'infolettre du Lab IA est une lettre d'information mensuelle sur les actualités du Lab IA d'Etalab, les échanges, expérimentations, rencontres et outils autour de l'usage des données et de l'IA pour améliorer l'action publique. Elle s’adresse à la communauté du Lab IA : participants aux AMI IA 1 et 2, datascientists de l'administration, chercheurs et prestataires de l'IA pour l'administration, et agents publics intéressés par la science des données et l'IA.

Vous pouvez vous y inscrire depuis ce lien, lire les infolettres précédentes et proposer des contenus pour les prochaines éditions.

Ci-dessous:

- Expérimentation de l'IA : les projets de l'AMI IA 1 se poursuivent en 2020

- Lancement de l'accompagnement scientifique de l'Inria avec 4 projets sélectionnés en 2020 (AMI IA 2) : rencontre avec l'équipe projet IA du Shom

- Retrouvez le webinaire d’Etalab sur la transparence des algorithmes publics

- Ouverture des décisions de justice : comment le Lab IA accompagne le Conseil d'Etat pour occulter les éléments d'identification des personnes grâce à l'IA et la pseudonymisation

- Atelier "Vis ma vie de data scientist" : introduction aux outils du data scientist

- PIAF participe aux 50 ans de la francophonie dans le monde : l'annotation continue

- Data science, impact du confinement et comment adapter ses modèles à la crise : rediffusion du datadrink en ligne du 4 juin

Notre sélection de ressources à visiter:

- Jeux de données, réutilisations, outils : la sélection d'Etalab des sorties du mois de mai sur data.gouv.fr

- Partagez vos talents numériques ! Proposé par la DINUM, le dispositif met en relation des agents de l'Etat désireux de mettres leurs compétences ponctuellement au service des administrations, et les services de l'Etat ayant besoin d'expertise numérique

- Le code des outils de traitement d'imagerie satellitaire, développé par le Cerema, a été mis en ligne en open source sur Github : libraries élémentaires généralistes et métiers, applications de traitement avancés et séquenceur sur des thématiques de l'aménagement du territoire et des risques

L'équipe du Lab IA d'Etalab

S'inscrire à l'infolettre du Lab IA / Se désinscrire

Expérimentation de l'IA : les projets AMI IA 1 se poursuivent en 2020

Les six projets de la première promotion AMI IA 1 accompagnés en 2019 par le Lab IA et la DITP se sont poursuivis en 2020. Sur les six projets, cinq ont permis de développer un algorithme d’intelligence artificielle qui a pu être testé avec les agents sur le terrain :

- L’Agence centrale des organismes de sécurité sociale (ACOSS), qui a développé un agent vocal d’aiguillage des appels et de traitement automatique des questions des usagers sur le chèque emploi associatif, poursuit le travail initié avec le prestataire et vise une mise en production de l’outil et un élargissement du périmètre ;

- La Direction départementale des territoires de l’Hérault (DDTM), qui a développé un outil de détection automatique des irrégularités d’occupation des sols, poursuit l’expérimentation avec des tests par les contrôleurs, l’amélioration de l’interface prévue et une éventuelle extension à d’autres cas d’usage (friches agricoles) ;

- L’Office français pour la biodiversité (OFB), qui a développé une interface de visualisation des données basée sur l’IA et l’analyse des données pour mieux orienter les contrôles de la police de l’environnement sur la pollution des eaux « diffuses », a expérimenté l’outil sur le terrain au 1er trimestre 2020 dans les deux départements pilotes, et évalue l’opportunité d’un élargissement à d’autres problématiques et d’autres départements ;

- L’Autorité de sûreté nucléaire (ASN), qui a développé un outil d’analyse des lettres de suites pour mieux guider les inspections, a poursuivi le projet avec le prestataire sur son budget propre et a été sélectionné dans le programme Entrepreneurs d’Intérêt Général (EIG) pour aller plus loin dans l’exploitation des lettres de suite et en faire un outil d’aide à la décision pour les inspecteurs ;

- La Direction Générale de l’Alimentation (DGAL) du Ministère de l’Agriculture et de l’Alimentation, qui a créé un outil pour mieux orienter les contrôles sanitaires dans les restaurants, a déployé l’outil auprès de ses inspecteurs dès novembre 2019. L’outil pourra être mutualisé avec d’autres services, le scraping d’autres données est prévu dans le cadre d’un partenariat avec le prestataire, et l’algorithme vise à être amélioré, notamment grâce au recrutement de data scientists au sein du ministère.

- Le CHU de Toulouse, qui a développé un outil d’extraction d’information dans les comptes rendu médicaux, étudie la possibilité d’intégrer l’outil d’annotation dans les SI du CHU et cherche d’autres moyens pour poursuivre l’expérimentation de l’IA.

Le 23 Juin, dans le cadre de l’accompagnement des projets AMI IA 2 organisé avec la DITP, Philippe Allamand, porteur du projet IA de la DDTM, a partagé son expérience avec les porteurs de projets AMI IA 1 : l’outil développé a notamment nécessité une phase d’annotation pour apprendre à l'algorithme à repérer automatiquement les constructions illégales : cette phase a mobilisé 4 agents sur une période de 4 semaines, à raison d'1 à 2 heures par jour.

« Dans le cadre du POC en 2019, nous avons réussi à détecter automatiquement des objets avec un résultat assez satisfaisant, mais pas de comparer leur présence dans le temps. Cette fonctionalité est importante pour nous, afin d'éliminer les objets prescrits (qui existent depuis plus de six ans). Suite à cette expérimentation et grâce à des financements internes, nous avons pu améliorer le modèle en augmentant le nombre d'annotations, en rajoutant des zones de détection de manière manuelle (zones à enjeux) et comparer l'existence des objets détectés dans le temps. Aujourd’hui, nous attendons le retour des contrôleurs sur l’efficience de l’outil pour aller plus loin (aux premiers retours : oui). Nous recherchons alors un appui des équipes nationales pour porter, développer et généraliser cet outil», explique Philippe Allamand.

Dans les six administrations accompagnées, l’AMI IA a permis d’initier une démarche d’expérimentation et de créer une dynamique autour des projets.

Lancement de l'accompagnement scientifique de l'Inria avec 4 projets sélectionnés en 2020 (AMI IA 2) : rencontre avec l'équipe du projet IA du Shom

Quatre projets exploratoires techniquement et sélectionnés par l’Appel à Manifestation d’Intérêt en intelligence artificielle (« AMI IA 2 ») en 2020 bénéficient d’un accompagnement scientifique des équipes de recherche de l’Inria. Piloté par le Lab IA et la DITP, les quatre projets bénéficient de l’apport direct de la recherche pour développer un prototype fonctionnel au service de l’action publique.

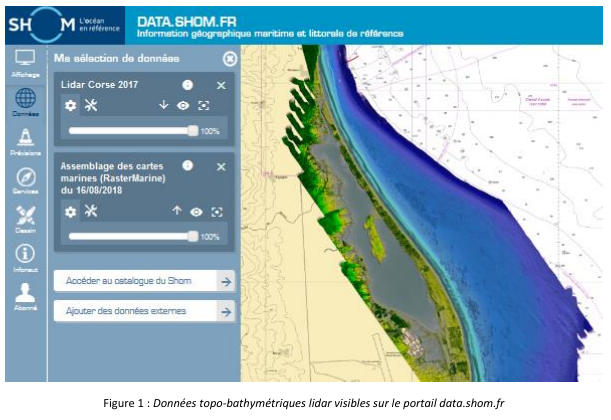

Rencontre avec Julian Le Deunf, expert métier et data scientist de l’équipe projet, et Steve Oudot, chercheur à l’Inria Saclay dans l’équipe DataShape, sur le lancement du projet IA du Service hydrographique et océanogaphique de la marine (Shom), sélectionné parmi les 4 projets scientifiques. A partir des mesures aéroportées par lidar bathymétrique (laser) prises sur le littoral français via le projet Litto3D®, l’IA permettra d’améliorer la production du référentiel du littoral en automatisant partiellement le traitement effectué par les agents.

L’apport de la recherche sur l’IA pour améliorer le soutien aux politiques publiques

« En faisant appel au monde de la recherche, nous avons plus d’interactions possibles qu’avec un prestataire, une réflexion sur les outils et les performances nécessaires étant donné le type de données que l’on utilise. On teste des idées, on tente des approches : on a la flexibilité nécessaire pour expérimenter. Par ailleurs, la littérature sur les données de cartographie est spécifique et relativement limitée : en explorant l’outil adéquat, nous pourrons aussi bien améliorer notre chaîne de traitement pour toute la gamme de profondeur (quelques mètres en Normandie, et jusqu’à cinquante mètres de profondeur en Polynésie française) et de morphologie. Ce qui est également intéressant dans cette approche expérimentale avec la recherche, c’est que nous pourrons chercher les biais d’apprentissage dans les données de façon beaucoup plus fine » explique Julian Le Deunf, de l’équipe projet Shom.

« Il s’agit là d’un problème très concret, avec un type de données très particulier. Les outils que nous développons d’habitude chez DataShape sont génériques, non reliés à un type de données précis. Par exemple, nous développons des familles de descripteurs dont la construction et les propriétés (invariance, stabilité) sont valables dans des cadres très généraux, et qui peuvent donc servir d’entrée à des algorithmes d’apprentissage dans une multitude de contextes. Avec ce projet, nous allons nous attacher à affiner nos outils sur un type particulier de données et à nous adapter aux caractéristiques très spécifiques, avec un souci très pragmatique d’efficacité. Au vu de la structure des données que nous avons pu consulter, nous sommes optimistes sur le fait que nos outils puissent fonctionner, en combinaison avec d’autres outils d’analyse statistique. Toutefois, une étape d’adaptation et de paramétrage sera nécessaire, c’est cette étape qui sera au cœur du projet. L’avantage de cet accompagnement scientifique pour le Shom est l’accès à des outils avancés développés chez DataShape, et au-delà, à l’expertise développée au sein de l’écosystème d’Inria Saclay. », ajoute Steve Oudot, de l’équipe projet DataShape.

Un projet complexe techniquement : la cartographie des fonds marins et des zones du littoral de métropole et d’outre-mer

« Le projet s’intéresse à un type de données 3D (latitude, longitude, profondeur) exploitées en nuage de points : l’idée est de supprimer les données ne correspondant pas à la bathymétrie (surface d’eau, bruit, banc de poissons…) pour cartographier les fonds marins et les zones du littoral. Aujourd’hui, ce travail est fait essentiellement de façon manuelle car nous n’avons pas trouvé d’outil qui permette d’automatiser ces traitements : l’objectif est de semi-automatiser cette partie du traitement pour réaliser la production du référentiel du littoral de métropole et d’outre-mer. La cartographie a un impact majeur sur la navigation, l’étude des effets du changement climatique et la connaissance de l’écosystème des fonds marins, ainsi le traitement des données nécessite une grande rigueur », explique Julian Le Deunf.

« Effectivement, il y a une exigence de qualité nécessaire étant donné l’objectif de référence pour le littoral de ce type de donnée. Ce projet est complexe étant donné les multiples composantes de la donnée dans la détection du fond de l’océan, et l’exigence de qualité en sortie de traitement. Très concrètement, une cartographie erronée des fonds marins pourrait mettre en danger la navigation des bateaux. Tout l’enjeu se situe dans le fait de perdre le moins possible de « données valides », c’est-à-dire obtenues lorsque le signal du laser mesure bien le fonds de l’océan (ou à défaut un obstacle statique comme une épave, que l’on doit modéliser). Jusqu’ici, la détection et le traitement des « faux positifs » et des « faux négatifs » nécessitait un arbitrage de l’agent et des corrections manuelles importantes. On veut automatiser cette partie en évitant le plus possible les « faux négatifs », soit avoir une donnée prédite « négative » alors qu’elle ne l’est pas (typiquement supprimer une épave qui sortirait du fond moyen).

Une autre difficulté spécifique au projet repose sur le fait que le « bruit » autour des données a une structure très particulière. Par exemple, l’hypothèse de bruit centré, très commune en analyse statistique, n’est ici pas du tout vérifiée : en fait le bruit est fortement décentré, à cause notamment d’un premier retour fort au moment du contact avec la surface d’eau, ainsi que d’une diffusion importante de la lumière au-delà en raison de la turbidité de l’eau. A cela s’ajoute encore l’environnement marin, avec par exemple les algues ou les bancs de poisson. Tout cela rend la modélisation du bruit très complexe.

Enfin, un dernier point important est que l’on cherche à assurer une certaine cohérence spatiale dans la reconstitution du fonds marin, ce qui fait que notre problème peut s’apparenter à certains problèmes de traitement d’image ou de la géométrie 3D, avec toutefois des différences notables dans les fonctions d’objectif et dans les modèles de bruit.» explique Steve Oudot.

Trois autres projets sélectionnés par l’AMI-IA 2 bénéficieront d’un accompagnement scientifique avec les équipes de recherche de l’Inria :

- Direction générale de la concurrence, de la consommation et de la répression des fraudes : détecter les clauses et pratiques abusives dans les contrats, devis et factures

- Institut national de l'information géographique et forestière (IGN) : faciliter le calcul du positionnement des points de référence terrestre à partir des données satellites

- Cour de cassation : identifier les divergences de jurisprudence

Retrouvez le webinaire d’Etalab sur la transparence des algorithmes publics

A revoir en ligne : ici

La loi pour une République numérique a posé le principe de transparence des algorithmes publics, notamment quand ils sont utilisés pour prendre des décisions administratives individuelles. Le jeudi 25 juin, Etalab a organisé un webinaire pour répondre à vos questions : qui est concerné ? Quels algorithmes ? Quelles obligations ? Quelles sanctions en cas de non-respect des obligations ? Comment faire, concrètement ?

Simon Chignard, Soizic Penicaud et Perica Sucevic (Etalab) y ont présenté le contexte juridique (loi République numérique et RGPD), les obligations des administrations (faire figurer une mention explicite, fournir une information individuelle, fournir une information générale), avec des mises en pratique et exemples de mise en œuvre par des administrations, et une présentation des ressources mises à disposition par Etalab : retrouvez ici le guide d’Etalab sur les algorithmes publics : pourquoi et comment les expliquer ? mis à jour le 24 juin 2020 avec une fiche pratique sur l’obligation de mention explicite.

Quelques pistes clés pour mettre en œuvre les obligations :

- Recenser les principaux traitements algorithmiques qui fondent des décisions administratives individuelles

- Publier la liste sur votre site web et la rendre facilement trouvable. Exemple : Pôle emploi

- Apposer la mention explicite, en utilisant au besoin l’exemple de mention proposée par Etalab

- Préparer des éléments pour les réponses d’informations individuelles à la demande

Si vous souhaitez qu’Etalab vous accompagne sur ces questions, vous pouvez nous contacter à l’adresse algorithmes@etalab.gouv.fr

Ouverture des décisions de justice : comment le Lab IA accompagne le Conseil d'Etat pour occulter les éléments d'identification des personnes grâce à l'IA et la pseudonymisation

Suite à la publication décret n° 2020-797 du 29 juin 2020, les décisions des juridictions judiciaires et administratives seront mises à la disposition du public. Pour ouvrir ces décisions au grand public, de nombreuses informations sensibles et à caractère personnel doivent être supprimées avant publication.

Depuis juin 2019, le Lab IA d'Etalab accompagne le Conseil d'Etat dans l'exploration d'un outil d'intelligence artificielle qui in fine permettra de publier les décisions de justice en données ouvertes. Cet outil repose sur une solution de Traitement Automatique du Langage Naturel (TALN, ou NLP en anglais) avec l'objectif de fournir une solution plus flexible et performante que celles utilisées aujourd'hui manuellement. Voir aussi :

- Démonstration de l’outil d’IA de pseudonymisation open source développé par le Lab IA pour le Conseil d’Etat

- Les guides d’Etalab : pseudonymiser des documents grâce à l’IA

Le programme Entrepreneurs d'Intérêt Général (EIG) travaille également avec la Cour de Cassation pour développer les outils nécessaires à la publication de ces données :

- Le défi EIG 3 OpenJustice avec la Cour de Cassation : ouvrir la jurisprudence par la pseudonymisation des données

- Le défi EIG 4 Label avec la Cour de Cassation : accélérer l’ouverture des décisions de justice.

Par ailleurs, la Cour de Cassation bénéficie également d’un accompagnement scientifique du Lab IA d’Etalab pour le développement d’une solution d’identification des divergences de jurisprudence, dans le cadre des projets AMI IA 2.

Atelier « Vis ma vie de data scientist » : introduction aux outils du data scientist

Dans le cadre de l’atelier de formation « Vis ma vie data scientist » du 11 juin, réservé aux porteurs de projets IA de l’Appel à Manifestation d’Intérêt en intelligence artificielle (AMI IA 2), le Lab IA a conduit une formation en ligne pour faire découvrir le déroulement et les outils d’un projet de data science à travers trois cas d’études des données disponibles sur data.gouv.fr.

Voici les trois notebooks développés présentés à cette occasion respectivement par Robin Reynaud, Julien Denes et Kim Montalibet (Etalab) :

PIAF participe aux 50 ans de la francophonie dans le monde : l’annotation continue

Pour construire les ressources nécessaires pour permettre aux intelligences artificielles de parler français, « Pour des IA francophones » (PIAF) a mis en ligne une plateforme d’annotation pour écrire des questions réponses. Cela permet de créer de façon collaborative un jeu de donnée pour entraîner des IA à répondre à des questions en français. En juin, PIAF a publié la dernière version du jeu de données, avec deux fois plus de questions (environ 7500 aujourd’hui. Plus on a de questions, meilleure sera notre IA. Pour inviter le grand public francophone à participer, PIAF participe aux 50 ans de la francophonie dans le monde : l’annotation continue avec un grand annotathon en ligne jusqu’en septembre.

Data science, impact du confinement et comment adapter ses modèles à la crise : rediffusion du datadrink en ligne du 4 juin

Le jeudi 4 juin de 16h à 17H30, le Lab IA a organisé un datadrink virtuel sur le thème Data science & impact du confinement : rediffusion ici.

- Baptiste Coulmont, professeur de sociologie : travaux d'analyses et de visualisation de différents indicateurs : "Dataconfinement: la chute"

- Aliette Cheptiski et Mikael Beatriz, du département de la Conjoncture de l'INSEE : travaux d'estimation de la perte d'activité et adaptation de leur méthodologie à la crise sanitaire actuelle.

- Pierre Camilleri de l'équipe Signaux Faibles : modèle de prédiction de la défaillance des entreprises et évolutions en cours pour s'adapter au contexte de crise.

Si vous avez des suggestions ou souhaitez présenter vos projets pour un prochain datadrink (10 minutes de présentation suivies de 5 minutes de questions), contactez-nous.

Notre sélection de ressources à visiter:

- Jeux de données, réutilisations, outils : la sélection d'Etalab des sorties du mois de mai sur data.gouv.fr

- Partagez vos talents numériques ! Proposé par la DINUM, le dispositif met en relation des agents de l'Etat désireux de mettres leurs compétences ponctuellement au service des administrations, et les services de l'Etat ayant besoin d'expertise numérique

- Le code des outils de traitement d'imagerie satellitaire, développé par le Cerema, a été mis en ligne en open source sur Github : libraries élémentaires généralistes et métiers, applications de traitement avancés et séquenceur sur des thématiques de l'aménagement du territoire et des risques